Сучасні алгоритми визначення релевантності тексту є досить складними. Для розуміння багатьох моментів варто розглянути, з чого все починалося. У далекому 20 столітті було розроблено алгоритм TF-IDF. Алгоритм дозволяє оцінити важливість слова чи терміна у документі, що є частиною певної колекції.

TF (term frequency) – частота слова, що дозволяє оцінити важливість будь-якого слова в рамках документа. TF – це відношення числа входження слова до загальної кількості слів у документі. Тобто простими словами чим частіше слово зустрічається всередині документа, тим більша умовна вага має це слово.

IDF (inverse document frequency) – зворотна частота документа. Тобто IDF – інверсія частоти з якою слово зустрічається над одному документі, а межах всіх документів певної колекції. Таким чином, IDF зменшує вагу часто вживаних слів та термінів.

Ми не будемо у статті наводити точні формули та розраховувати значення коефіцієнтів. Хто хоче, може детальніше ознайомитися з формулами на сторінці Wikipedia. Також можна почитати про основоположника цієї теорії – Карен Спарк Джонс.

По роботі алгоритму можна зробити простий висновок: максимальна вага отримає слово з високою частотою всередині одного документа і низькою частотою в усіх документах колекції.

Вплив таких on-page факторів як просте збільшення ключових слів досить мало. Давно такого немає, щоб хтось просто збільшив кількість ключових слів чи синонімів на сторінці та випередив конкурентів у пошуковій видачі. Таким чином, можна зробити висновок, що пошукові системи використовують складніші математичні алгоритми. Враховуються зв’язки між словами, наявність додаткових слів (LSI) тощо. Тобто які слова з яким використовується найчастіше, а з яким взагалі не використовується і т.д.

Більше інформації можна знайти в статті MOZ і почитати у Wiki про розподіл Диріхлі.

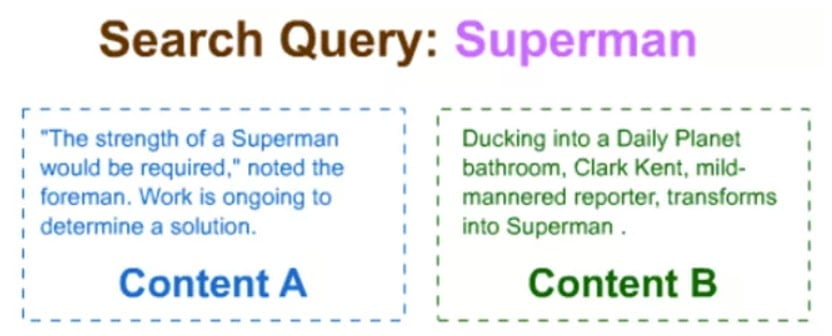

Яскравий приклад роботи пошукових алгоритмів щодо релевантності тексту. Пошук за словом Superman.

Застосовуючи статистику про спільне вживання слів, пошукова система зрозуміє, що Кларк Кент і Дейлі Планет часто використовуються зі словом Супермен. З погляду пошукової системи, другий текст більш релевантний, ніж перший. Навіть незважаючи на те, що в першому є пряме входження ключового запиту і знаходиться вище, ніж у другому варіанті.

Наведені приклади не дають відповіді те, як працюють алгоритми пошукових систем щодо релевантності тексту. Але ці приклади дозволяють зрозуміти, що пошукові системи враховують велику кількість різних змінних і мають складні математичні моделі.

Те, що на сторінці 10 разів повторюється ключове слово, не означає, що текст буде справді релевантним запиту. Недоречне використання спеціальних термінів усередині тексту також не підвищить його вагу в очах пошукових систем. Єдиний вихід – писати такий текст, який надасть усі можливі відповіді відвідувачеві. Такий текст може написати фахівець у своїй справі. Але далеко не кожен професіонал зможе сісти і написати пов’язаний текст, що легко читається. До того ж, вартість текстів написаних професіоналами буде досить високою.

Як вихід із цієї ситуації – використання перевірених часом фахівців копірайтерів, які, використовуючи докладні технічні завдання, можуть написати якісний текст. Такий текст буде сприйматися пошуковими системами і буде цікавий відвідувачам.

Якщо ви не впевнені в тому, що зможете написати докладний текст, довірте це питання фахівцям. Наш відділ копірайтингу створив десятки якісних блогів, які приносять добрий трафік на сайти.